梁文锋亲自参与的DeepSeek最新论文发布了!

这次,团队公布了DeepSeek-V3如何在训练和推理过程中解决"硬件瓶颈"的方法。

DeepSeek-V3仅使用2048块H800就能达到与超大规模集群(数万块GPU)相当的训练效果,这主要归功于四项创新技术:

内存优化

多头潜在注意力(MLA)

计算优化

混合专家模型(MoE)与FP8低精度训练

通信优化

多层网络拓扑与低延迟设计

推理加速

多token预测(MTP)

让我们深入了解这四项优化是如何发挥作用的。

软硬件协同的优化设计

在训练大模型的道路上,一直存在着"三座大山"。

首先是内存不够用。

现代大语言模型(如GPT、Llama)规模日益庞大,需要的存储空间激增。特别是它们使用的"注意力机制"会产生大量临时数据(KV Cache),占用大量显卡内存。

然而,高性能显存的容量增长速度太慢,每年仅增加不到50%,远远跟不上需求。

其次是计算效率低。

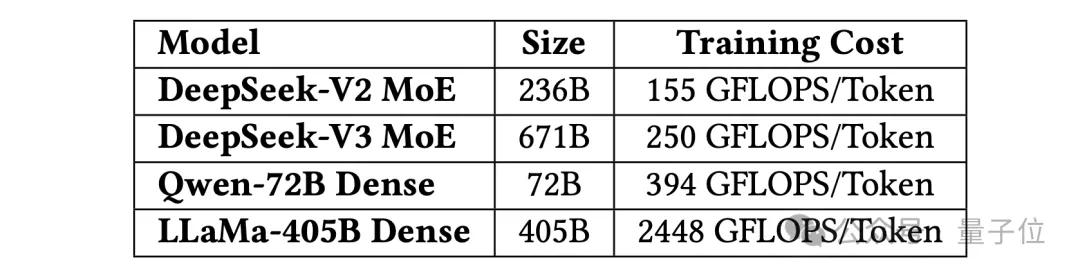

训练超大规模模型需要海量计算资源,传统"稠密模型"(如Llama-3)每次计算都需要激活所有参数,导致计算成本极高。

虽然"混合专家模型"(MoE)效率更高,但它需要复杂的通信机制(如专家间数据传输),对网络带宽要求极高。

最后是通信速度慢。

多GPU并行训练时需要持续的数据交换,这个过程会产生延迟。即使使用高速网络(如InfiniBand),这种延迟仍会降低整体训练速度,尤其在处理长文本或需要实时响应时更为明显。

这篇论文就致力于解决这些关键问题。

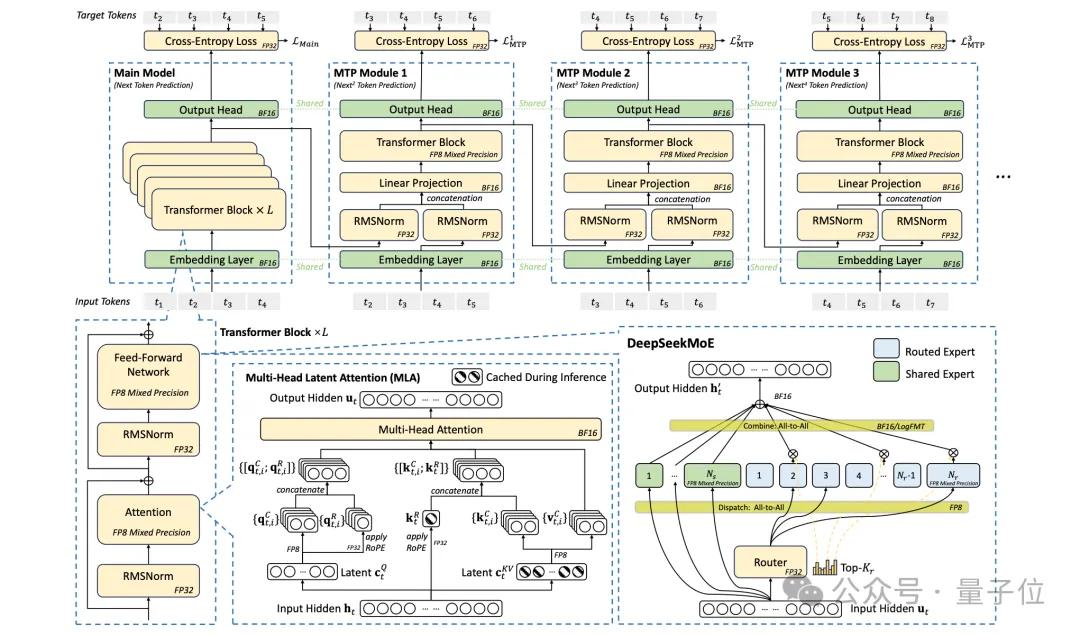

△DeepSeek-V3的基本架构

首先,DeepSeek团队对内存进行了优化,采用多头潜在注意力(MLA)来减少"键值缓存"(KV Cache)的内存占用。

传统模型中每个注意力头都需要独立缓存键值对,而MLA通过投影矩阵将所有头的键值对压缩成一个更小的"潜在向量",只需缓存这一个向量。

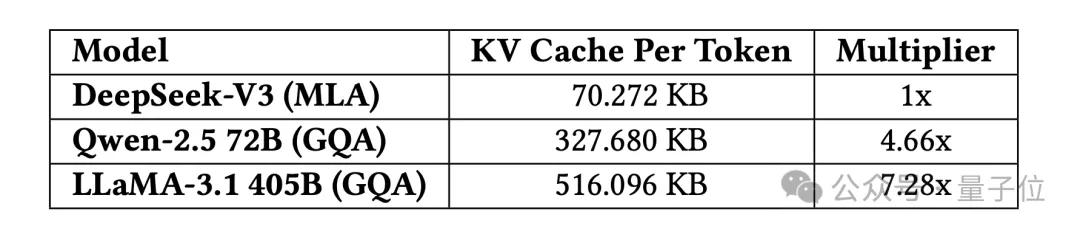

与其他模型(如LLaMA-3、Qwen-2.5)相比,DeepSeek-V3的KV缓存大小每token仅需70 KB,仅为传统方法的⅐到¼,大幅降低显存压力,特别适合长文本处理。

在计算优化方面,DeepSeek-V3采用了MoE和FP8低精度训练。

MoE将模型参数分成多个"专家",每次只激活部分专家处理输入,显著减少实际计算量。

DeepSeek-V3采用这一思路,虽然总参数量达6710亿,但每次仅激活370亿参数,训练成本仅为同规模稠密模型的⅒(如Llama-3.1训练成本是其近10倍)。

正因为推理时激活参数少,DeepSeek-V3可在消费级GPU(如售价1万美元的显卡)上运行,每秒生成近20个token,适合个人或中小型企业使用。

FP8低精度训练不同于传统的BF16(16位浮点)训练,可将内存占用和计算量减半,同时通过"精细量化"(如分块压缩)保持精度。

DeepSeek-V3首次在开源大模型中成功应用FP8训练,将训练成本降低50%,精度损失仅小于0.25%。

在通信方面,DeepSeek-V3也实现了重要优化。

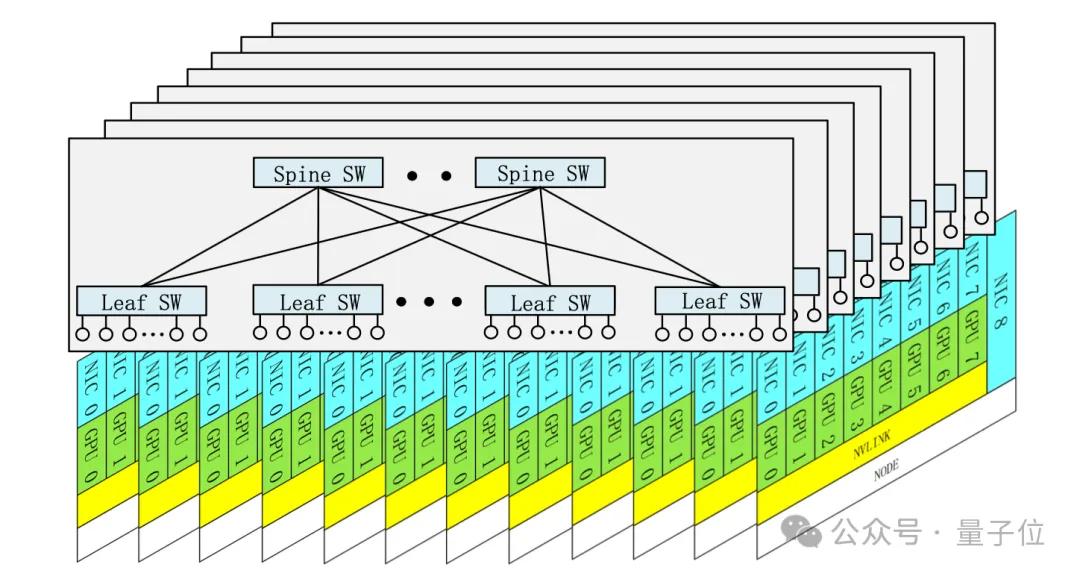

例如多层胖树网络(Multi-Plane Fat-Tree)将集群网络分为多个"平面",每个GPU连接到独立的网络平面,避免不同任务的流量冲突(如训练与存储通信分离)。

与传统三层网络相比,这种两层结构使成本降低40%,延迟减少30%,并支持上万GPU规模扩展。

在推理时,DeepSeek-V3将"注意力计算"与"专家间通信"分阶段执行,通过流水线并行(DualPipe)实现GPU计算与数据传输同步进行,避免空闲等待,使吞吐量提升近1倍。

在推理加速方面,DeepSeek-V3采用了多token预测(MTP)技术。

不同于传统模型每次只能生成1个token,MTP通过轻量级子模型并行预测多个候选token(如一次预测2-3个),经验证后选择最优结果。

实验显示,生成速度提升1.8倍,每秒生成token数从10个增至18个,同时保持80%-90%的准确率。

以上就是DeepSeek-V3通过硬件与模型协同设计,实现高效训练和推理的关键技术。

除此之外,这篇论文对未来工作也具有重要启发。

从"被动适配"到"主动设计"

了解当前AI硬件瓶颈后,我们可以对下一代AI硬件提出期待。

DeepSeek团队从五个维度展望未来,希望从过去的"被动适配"逐步过渡到"主动设计"。

1、低精度计算支持

针对计算效率低的问题,下一代AI硬件需要提高累积寄存器精度,支持FP32累加或可配置精度(如训练用FP32,推理用FP16),以在不同模型训练和推理需求中实现性能与准确性的平衡。

硬件还需要支持本地细粒度量化,使张量核心能直接接收缩放因子(scaling factors),在计算单元内部完成量化和反量化,减少数据搬运。

此外,建议支持LogFMT(对数浮点格式),在相同比特宽度下提供更高精度,并提升编解码速度。

2、扩展与扩展融合

针对传输速度慢的问题,建议未来硬件将节点内(纵向扩展)和节点间(横向扩展)的通信整合到统一框架中,通过集成专用网络流量管理协处理器实现。

这种设计可以降低软件复杂性并最大化带宽利用率,包括:

统一网络适配器:设计连接统一扩展和缩减网络的NIC(网络接口卡)或I/O芯片,使网卡直接支持所有通信需求。

专用通信协处理器:将数据搬运、Reduce、类型转换等任务卸载到专用硬件,释放GPU SM资源。

智能传输功能:自动转发数据,支持广播和汇总操作,并自动处理数据顺序问题。

动态带宽分配:支持流量优先级调度(如EP通信>KV缓存传输)。

CPU-FPU高速互联:使用NVLink连接CPU与GPU,进一步优化节点内通信。

3、网络拓扑优化

针对网络卡顿问题,建议以太网供应商开发专门针对RDMA工作负载优化的RoCE交换机,移除不必要的以太网功能。

同时需要优化路由策略,支持自适应路由(Adaptive Routing,AR),通过动态多路径数据包发送显著提升网络性能。

还可以通过虚拟输出队列(VOQ)改进流量隔离和拥塞控制机制,有效隔离不同流量,避免拥塞。

4、内存系统优化

针对AI模型上下文记忆能力不足的问题,可采用3D堆叠DRAM技术,将内存芯片如三明治般叠放在计算芯片上。

或者借鉴Cerebras的方案,直接在晶圆上进行集成工程,最大化内存带宽和计算密度,提升硬件记忆容量。

另一方案是在硬件存储层部署稀疏注意力加速器,让硬件直接协助记忆整理,只保留关键信息。

5、鲁棒性与容错

针对大规模训练中网络闪断、GPU故障导致任务失败的问题,期待下一代硬件能支持链路层重试和快速故障切换,在中断后快速切换到备用路线。

还可引入基于信用的流控(CBFC)和智能拥塞控制算法(如RTT-CC),防止网络集体瘫痪。

简言之,下一代AI硬件需要在计算速度(低精度计算+本地细粒度量化)、通信效率(直连网络+智能路由)、记忆能力(3D内存+近存计算)和系统稳定性(自愈网络)等方面全面提升,以更好地支持大模型训练,实现高效扩展。